Google I/O 2022: Ctrl-F Voor Het Echte Leven

Een paar keer overgeslagen vanwege corona; de aankondigingen stelden de afgelopen jaren weinig voor, maar dit jaar startte Sundar Pichai Google I/O weer met een keynote voor live publiek! In dit blog lees je meer over de Google I/O ontwikkelaarsconferentie van 2022 en mijn persoonlijke highlights.

Voor als je spoilervrij de volledige Google I/O 2022 keynote (2 uur) wil kijken:

Hey Google!

De focus lag dit jaar op multimodal AI. Een goed voorbeeld hiervan was de demo van de Digitale Assistent, die nu ook op basis van oogcontact te activeren is in plaats van enkel met het spraakcommando: “Hey Google!”.

Google heeft 5 ML-modellen samengevoegd (hoofdoriëntatie, nabijheid, blikrichting, lipbeweging en contextual awareness) in een contextbewuste AI die lichaamstaal detecteert.

Multimodal AI is een functionaliteit waarin verschillende datatypes (beeld, tekst, spraak, locatie) worden gecombineerd met meerdere Machine Learning-modellen. Multimodal AI presteert vaak veel beter dan een enkel ML-model in real life scenario’s.

TL;DR (Too Long; Didn’t Read)!

“Wouldn’t life be better if more things had a TL;DR?”

Sundar Pichai

Heb je ook zo’n hekel aan lange mails, notulen of een opname van de alweer uitgelopen maand update (via geautomatiseerde transcripties)? Google gaat een TL;DR functie toevoegen aan Google Workspace die, met behulp van machine learning, automatisch de belangrijkste punten uit een document zal opsommen.

Ctrl-F Voor Het Echte Leven

Google gaat zijn knowledge graph combineren met search en augmented reality, zodat je de fysieke wereld kan verkennen met de slogan: “Search your world, any way and anywhere”. In de toekomst kun met behulp van je camera of AR-bril, een vraag stellen en relevante informatie bekijken in de context van de wereld om je heen. Het is als Ctrl-F voor de echte wereld.

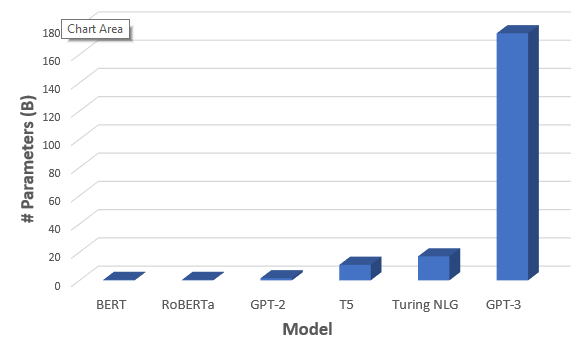

Wie heeft het grootste taalmodel?

2022 is het jaar van de taalmodellen. Elke week komt er wel een nieuwe uit met meer parameters dan de vorige! Twee jaar geleden schreef ik over GPT-3, toen het grootste model met 173 miljard parameters, Google toonden tijdens I/O hun nieuwste Pathways Language Model (PaLM) met 540 miljard parameters! Waar GPT-3 voornamelijk op Engelse data is getraind, “spreekt” PaLM meerdere talen.

Binnenkort zijn deze modellen te testen in de AI Test Kitchen.

Google I/O YouTube kanaal

Wil je meer informatie over de bovenstaande features, dan is er vast nog een sessie te vinden op het Google Developers YouTube kanaal, die hier dieper op in gaat. Ik weet in ieder geval al waar ik de komende weken mijn kennisonderhoud aan besteed.

Heb je nog vragen naar aanleiding van de keynote? Neem contact op, we helpen je graag!