Wat is GPT-3? Weer Een Stapje Verder in Het Decennium Van De Digitale Assistent

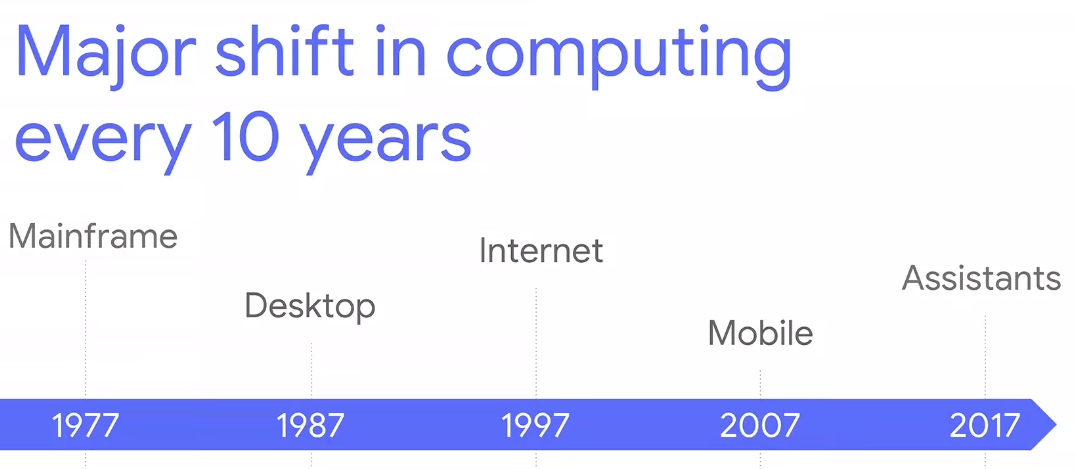

Afgelopen jaren gaan veel van mijn blogs over de ontwikkeling van Google in hun transitie van “Mobile First” naar “AI First”. Een belangrijk onderdeel daarvan is de digitale assistent. Google bestempeld deze zelfs als de volgende grote verschuiving in computergebruik:

Het duurde niet lang nadat OpenAI GPT-3 lanceerde, de derde (nu in closed beta) in een reeks NLP-modellen, om met de hashtag #gpt3 viral te gaan. Om maar meteen met de deur in huis vallen, check deze (digital marketing) demo’s die in zeer korte tijd gebouwd zijn met de GPT-3 API:

Handige apps bouwen

I just built a *functioning* React app by describing what I wanted to GPT-3.

I'm still in awe. pic.twitter.com/UUKSYz2NJO

— Sharif Shameem (@sharifshameem) July 17, 2020

Advertentieteksten schrijven

How do you make writing ad copy fun? 🤔

Give it to #GPT3

Instantly create dozens of versions in seconds pic.twitter.com/hfKxz3zfmN

— Chris Frantz (@frantzfries) July 29, 2020

Clickbait titels verzinnen

Text completion and the combination of style rewriting and text completion. What else should I add to round out the writing tools? GPT-3 #gpt3 pic.twitter.com/XSc6n1hqE2

— Carlos E. Perez Mastodon ceperez@sigmoid.social (@IntuitMachine) July 25, 2020

Lay-out ontwerpen

This changes everything. 🤯

With GPT-3, I built a Figma plugin to design for you.

I call it "Designer" pic.twitter.com/OzW1sKNLEC

— jordan singer (@jsngr) July 18, 2020

Nette email schrijven

GPT-3 is going to change the way you work.

Introducing Quick Response by OthersideAI

Automatically write emails in your personal style by simply writing the key points you want to get across

The days of spending hours a day emailing are over!!!

Beta access link in bio! pic.twitter.com/HFjZOgJvR8

— OthersideAI (@OthersideAI) July 22, 2020

Meer memes!

Tired: Making your own memes

Wired: Asking @OpenAI's #gpt3 to make memes.Amazed to see how much of cultural subtext and nuance language models can pick up on. cc: @gwern @gdb pic.twitter.com/eBrFAWiZhA

— Mrinal Mohit (@wowitsmrinal) July 25, 2020

Met George Washington praten

We built a system powered by GPT-3 artificial intelligence that lets you learn anything from anyone.

You talk to them.

And they talk back.

Sound on. pic.twitter.com/IG72Kh69lk

— Mckay Wrigley (@mckaywrigley) August 7, 2020

Mind blown! 🤯 Maar hoe dan?

Wat is GPT-3?

GPT-3 (Generative Pretrained Transformer versie 3) is een Natural Language Processing (NLP) model met als doel om taal beter te begrijpen, zodat bijvoorbeeld een digitale assistent gemakkelijk een vraag kan vertalen naar een actie en natuurlijk overkomende conversaties kan voeren.

GPT-3 is in bijna alles “redelijk” goed

Waar BERT van Google, ook een NLP-model, het doel heeft om zoekopdrachten beter te begrijpen. Is GTP-3 niet gefinetuned voor een specifieke taak. Het doel van GPT-3 is om met zo min mogelijk toezicht zoveel mogelijk NLP-taken uit te kunnen voeren. Je kunt GPT-3 “primen” om een programmeur, een creatieve copywriter of een beroemd personage te worden.

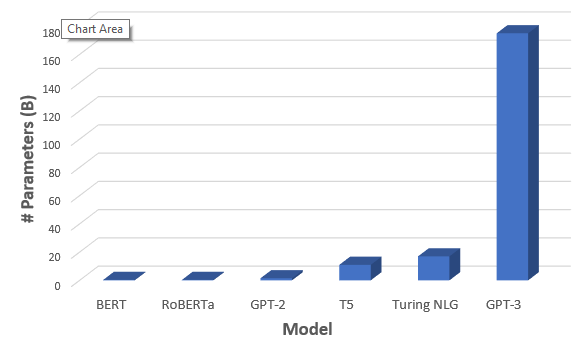

Dit is allemaal mogelijk, omdat GTP-3 bestaat uit 173 miljard parameters. Bijna tien keer zoveel als het vorige grootste model; Turing-NLG van Microsoft. Om dit even in perspectief te zetten: het kost $4.6 miljoen aan computerkracht om dit model te trainen in de cloud of 355 jaar op 1 Tesla V100, de snelste deep learning GPU op de markt.

GPT-3, SEO en digital marketing

In een vervolg ga ik dieper in op de invloed van GPT-3 op SEO en digital marketing. Met een beetje geluk heb ik dan ook toegang tot de API. Een vraag wil ik alvast beantwoorden. De vraag die bijna altijd als eerst wordt gesteld na het zien van alle mogelijkheden: raken we nu allemaal onze baan kwijt?

Zeker niet! 🤖

- GPT-3 leert niet constant

- Kan niet onthouden wat die eerder gedaan heeft

- Is een momentopname van de data waarop het model getraind is

- Werkt niet aan / naar een bepaald doel (langere teksten die GPT-3 genereert zijn totaal random)

- Discrimineert, is racistisch en gebruikt zonder gêne complottheorieën (omdat het model is getraind op data van “het internet”)

GPT-3 is vooral een grote stap in de richting van een nuttige digitale assistent. NLP is daar een belangrijk onderdeel van. Hoe goed zal het volgende model zijn met meer dan 1 biljoen parameters?